Dans le petit monde en expansion des LLMs, une philosophie semble prédominer quand il s’agit de constituer les ensembles de données nécessaires à l’entrainement modèles, celle de la pêche au chalut. En gros, il s’agit de collecter le maximum de données par tous les moyens possibles pour nourrir le modèle. Tout y passe ou presque, en tous cas ce qui est numérisé et accessible sur internet : articles, livres numériques, catalogues, encyclopédies, textes législatifs, revues scientifiques, commentaires, posts, etc.

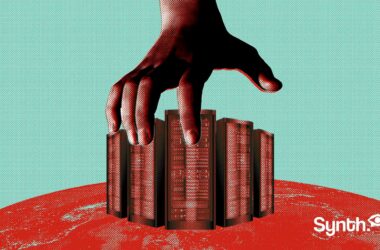

Fidèles au vieux dicton (souvent mal compris) « better ask for forgiveness than permission » attribué à la légende de l’informatique Grace Hopper, les big tech ont donc fait main basse sur tous les contenus possibles et imaginables pour fabriquer leurs modèles. Chacun d’entre eux a constitué un trésor de guerre de plusieurs milliards de mots, collectés sans consentement ni autorisation de la part des auteurs et créateurs concernés. La jurisprudence qui prévaut depuis l’apparition d’internet dans l’esprit populaire et qui sous-entend que sur le net, tout est gratuit, a servi de prétexte pour s’affranchir du droit d’auteur et de la propriété intellectuelle.

Certains n’hésitent d’ailleurs pas à comparer cet accaparement à une forme de comportement colonial ou la puissance dominante s’approprie les ressources disponibles au détriment des populations qui en dépendent, sans jamais offrir la moindre compensation. L’action en justice intentée par de nombreux auteurs, des artistes, des éditeurs de livres ou d’organes de presse comme le New York Times montre à quel point le sujet est sensible.

Pourtant, une autre voie était possible. Celle de la contribution volontaire. La théorie de la dignité des données (Data Dignity), apparait dans un article de la Harvard Business Review en 2018 publié par Jaron Lanier et E. Glen Weyl qui postule que les créateurs doivent être rémunérés pour les données qu’ils ont créées. À l’occasion d’une conférence donnée à Berkeley en septembre 2023, Lanier revient sur ce concept qu’il défend dans un article du New Yorker (There’s no AI) en expliquant que le procédé permettrait davantage de transparence et permettrait de mieux comprendre ces black box que sont les modèles en révélant les données qui s’y trouvent et en les attribuant correctement à leurs créateurs.

En mars dernier, Pierre Carl Langlais, un chercheur français a publié le plus grand corpus de données d’entrainement publiques pour LLMs (Common Corpus) sur la plateforme Hugginface. Common Corpus est le plus grand ensemble de données du domaine public publié pour la formation des LLM. Il comprend 500 milliards de mots provenant d’une grande diversité d’initiatives du patrimoine culturel. Multilingue, c’est à ce jour le plus grand corpus en anglais (180 milliards de mots), en français (110 milliards), en allemand (30 milliards de mots), en espagnol, néerlandais et italien et n’est composé que de sources ne posant pas de problèmes de droits d’auteur.

Un autre modèle est donc possible et ce sont désormais deux visions du monde qui s’affrontent. Pas étonnant que la plus humaniste et respectueuse viennent de ce côté de là de l’atlantique.