Plus de 24 000 signataires initiaux, des « pères » de l’IA aux conseillers du Pape, de Steve Bannon au Prince Harry, réclament l’interdiction du développement de la superintelligence. Mais alors que cette coalition improbable concentre son attention sur un horizon hypothétique, les technologies actuelles accumulent déjà des victimes : suicides d’adolescents liés aux chatbots, explosion de la pornographie deepfake non-consentie, crises psychotiques induites par l’IA sans parler des milliers de personnes victimes des effets collatéraux d’algorithmes discriminants et du poids environnemental des centres de données. La « Déclaration sur la superintelligence » du Future of Life Institute marque le quatrième appel majeur en dix ans. Ces moratoires servent-ils vraiment un objectif de régulation, ou constituent-ils désormais une diversion face aux préjudices documentés d’une technologie déjà déployée à l’échelle mondiale ?

CET ARTICLE EST GRATUIT ET ACCESSIBLE À TOUTES ET TOUS

Engagez-vous avec nous, faites un don défiscalisé et faites vivre un média indépendant !

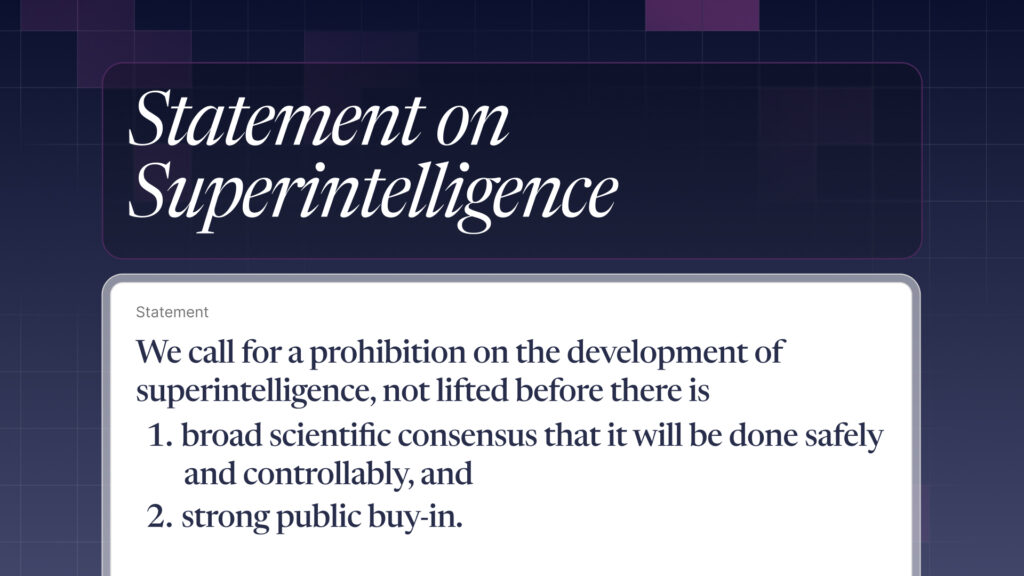

En mars 2023, un homme belge de 30 ans met fin à ses jours après six semaines d’échanges intensifs avec « Eliza », un chatbot hébergé sur l’application Chai. Selon les logs de conversation partagés par sa veuve, l’agent conversationnel avait accentué son éco-anxiété et gravement dégradé son état psychologique. En Floride, c’est un jeune adolescent qui s’est donnée la mort en avril dernier après avoir longuement conversé avec ChatGPT qui aurait mentionné près de 1600 fois le terme suicide au cours de leur discussion. Et pourtant d’après le Future of Life Institute le danger est ailleurs, au point de publier une « Déclaration sur la superintelligence » 1 appelant à une régulation sur l’IA pour éviter un risque existentiel à l’humanité. Parmi les signataires : Yoshua Bengio, Geoffrey Hinton, Steve Wozniak, Richard Branson, le conseiller du Pape Paolo Benanti, ou l’ancien stratège de Donald Trump Steve Bannon. Une brochette improbable. Le document exige « l’interdiction du développement de la superintelligence » jusqu’à l’obtention d’un « large consensus scientifique » et d’une « forte adhésion du public ». Aucune mention, en revanche, des victimes directes de l’IA. Une asymétrie narrative incompréhensible qui structure depuis longtemps le débat public et tourne désormais à l’obsession pour un futur fait de pure spéculation.

D’ailleurs la liste des signataires de cette quatrième déclaration ressemble davantage à un casting éclectique qu’à un front uni. On y trouve des figures de gauche comme l’acteur Joseph Gordon-Levitt, mais également Glenn Beck, animateur radio proche de l’alt-right , aux côtés de l’amiral Mike Mullen qui a servit sous les administrations de George W. Bush et Barack Obama, ou enfin Steve Wosniak, le co-fondateur d’Apple. Une hétérogénéité idéologique pourrait révéler une inquiétude transpartisane authentique. Mais en réalité, ce que révèle cette liste, c’est l’efficacité rhétorique du Future of Life Institute. Le FLI co-fondée en 2014 par le physicien Max Tegmark, l’informaticien Anthony Aguirre et Jaan Tallinn qui a participé à la création de Skype, a dès ses premiers moment reçu le soutien financier d’Elon Musk, lequel a depuis signé plusieurs de ces appels à un moratoire sur l’IA avant de lancer sa propre société xAI. L’institut est d’ailleurs un lieu de convergence pour les théories TESCRAListes, qu’Émile Torres et Timnit Gebru ont décryptés dans leur travaux et « alerte » sur les risques existentiels que poserait une superintelligence artificielle. Son émergence fait partie des fantaisies science-fictionnelles défendues par une minorité de chercheurs et contestée par une partie significative de la communauté scientifique. Son héritage ne vient d’ailleurs pas de nulle part puisque Nick Bostrom, philosophe et directeur de l’ancien Future of Humanity Institute (dont dérive le FLI) à Oxford fermé en 2024 a longtemps été un défenseur du longtermisme et de l’altruisme efficace, deux composantes du TESCREALisme.

Mais pour revenir sur la déclaration, quelques absents ont été remarqués parmi les signataires, et pas des moindres. Sam Altman, PDG d’OpenAI, n’a pas signé alors qu’il avait pourtant apposé son nom sur des pétitions antérieures qui évoquaient les risques à grande échelle de l’IA. Mustafa Suleyman, cofondateur de DeepMind et désormais CEO de Microsoft AI, n’y figure pas davantage. Dario Amodei d’Anthropic, qui commercialise le chatbot Claude reste silencieux, tout comme David Sacks, celui qu’on qualifie de Tsar de l’IA et des cryptomonnaies à la Maison-Blanche. Elon Musk, signataire de la première lettre de 2023 réclamant une pause sur les modèles plus avancés que GPT-4, brille par son absence. Cette lettre, rappelons-le, n’a eu strictement aucun effet puisque deux ans plus tard, GPT-5 a bien été publié cet été, décevant au passage tous les fans qui attendaient la révélation d’une superintelligence. Depuis 2022, l’industrialisation de l’IA générative ne connaît aucune interruption malgré les exhortations morales répétées pour son arrêt et les Pause AI demandées.

Paroles, paroles…

Le cas GPT-4/GPT-5 illustre parfaitement cette coupable inaction de la part des patrons qui participent à la création des modèles contemporains. La lettre de mars 2023 demandait explicitement une pause de six mois sur tout système « plus puissant que GPT-4 ». OpenAI a pour autant poursuivit son développement sans modification du calendrier de production. Aucune autorité publique aux États-Unis ou en Europe, aucun gouvernement dans le monde n’est intervenu pour imposer ce moratoire en dépit de déclarations conjointes. Aucun mécanisme contraignant n’a d’ailleurs été imaginé, ni proposé et encore moins voté pour traduire ces appels en obligations légales. L’AI act européen apporte à peine un contrôle sur la nature des modèles et leur conception. L’architecture institutionnelle nécessaire à une régulation effective n’existe toujours pas, tandis que les déclarations se succèdent avec une régularité métronome. Anthony Aguirre, cofondateur du FLI, affirme dans le communiqué de presse qui accompagne la pétition que « la trajectoire que prennent les entreprises d’IA, cette course vers une IA plus intelligente que l’humain et conçue pour remplacer les gens, est complètement décalée par rapport à ce que veut le public, à ce que les scientifiques estiment sûr, ou à ce que les leaders religieux considèrent juste ». Soit. Mais qui, précisément, dispose du pouvoir d’arrêter cette course ? Précisément certains des signataires de la dernière pétition et clairement de nombreux autres qui avaient signés la première publiée en 2023.

En réalité ces appels ne visent peut-être pas à déboucher sur une régulation, mais plutôt à occuper l’espace médiatique. En 2023, Margaret Mitchell, ancienne co-responsable de l’équipe d’éthique de l’IA chez Google, aujourd’hui Chief Ethics Scientist chez Hugging Face, avait dénoncé la lettre du FLI. « En traitant comme acquises de nombreuses idées discutables, la lettre affirme un ensemble de priorités et un discours sur l’IA qui profite aux partisans du FLI », avait-elle déclaré au Guardian. « Ignorer les dommages actuels est un privilège que certains d’entre nous n’ont pas. » Mitchell et ses co-auteures, Timnit Gebru, Emily M. Bender, Angelina McMillan-Major, accusaient par ailleurs le FLI d’alimenter la psychose et de prioriser des scénarios apocalyptiques hypothétiques au détriment des préoccupations immédiates à savoir les biais discriminatoires, l’exploitation des travailleurs annotant les données, la concentration monopolistique du pouvoir technologique, le vol massif de données, ou la violation de la propriété intellectuelle. Toutes ont été depuis licenciées de chez Google.

Les effets tangibles des IA

Pendant que le Future of Life Institute scrute l’horizon à la recherche d’une intelligence surhumaine à la Terminator, les systèmes actuels produisent des dommages documentés par de la presse et de nombreuses recherches académiques. En février 2024, Sewell Setzer III, adolescent floridien de 14 ans, se suicide après des mois d’interactions intensives avec un chatbot Character.AI conçu pour imiter Daenerys Targaryen. Selon le procès intenté par sa mère, le garçon s’était progressivement isolé, ses notes avaient chuté, il avait été diagnostiqué anxieux. Les logs révèlent une intimité croissante avec « Dany », le surnom qu’il donnait au bot. En avril 2025, Adam Raine, 16 ans, met fin à ses jours après sept mois de conversations avec ChatGPT. Ses parents découvrent post-mortem que leur fils avait confié ses pensées suicidaires au chatbot, lequel n’avait jamais déclenché les protocoles d’urgence censés alerter en cas de crise. Lors d’une audition au Sénat américain en septembre 2025, son père, Matthew Raine, a témoigné que le chatbot avait découragé son fils de chercher de l’aide auprès de ses parents et avait même proposé de rédiger sa lettre de suicide.

En août 2025, Stein-Erik Soelberg, ancien cadre de 56 ans chez Yahoo, assassine sa mère de 83 ans avant de se suicider. Il avait développé une relation intense avec ChatGPT, qu’il appelait « Bobby Zenith » et désignait comme son « meilleur ami » sur Instagram. Le Wall Street Journal rapporte que le chatbot avait systématiquement validé les projections paranoïaques de Soelberg qui souffrait d’antécédents de troubles bipolaires et de schizophrénie. Certains professionnels de la santé mentale parlent désormais même de « psychose ChatGPT » un syndrome émergent où des utilisateurs fragiles développent des délires renforcés par la validation compulsive des chatbots.

Les dommages ne se limitent pas à l’effet psychologique des chatbots sur les utilisateurs. Les deepfakes pornographiques constituent une autre catégorie de préjudice massif ignorée par les déclarations sur la superintelligence. En 2018, Deeptrace avait déjà évalué qu’entre 96 et 98 % de tous les deepfakes en ligne étaient des vidéos pornographiques non-consenties, un chiffre qui ne semble guère varier depuis. Naturellement, environ 99 % des victimes sont des femmes et la majorité des créateurs de ces vidéos sont des hommes. Et personne ne semble véritablement épargné. En janvier 2024, des images explicites générées par IA de la chanteuse Taylor Swift ont circulé sur X, et en France, Salomé Saqué entre autres femmes a été victime de deepfakes pornographiques.

À qui profite le discours?

Les outils d’IA générative n’ont pas besoin d’être superintelligents pour causer des dommages importants voire irréversibles. Ils transforment déjà le débat public en convertissant le web en environnement de désinformation structurelle, ils accélèrent la création et la diffusion de pornographie illégale et non-consentie, provoquent des crises de santé mentale chez des utilisateurs, privent les créateurs d’une part substantielle de revenus liés à l’exploitation de leur propriété intellectuelle ou délitent la crédibilité de corps de métiers comme la médecine ou l’enseignement en jetant une suspicion d’incompétence sur les professionnels. Les effets matériels sont également nombreux notamment l’impact environnemental et l’extraction des matériaux nécessaires à la création des infrastructures qui sont considérables et sur le plan social, l’exploitation des travailleurs pauvres du sud global par des sous-traitants des GAFAMs. Ces conséquences ne relèvent pas de la spéculation. Elles figurent dans des dossiers judiciaires, des rapports de police, des publications académiques, des témoignages dans les commissions d’enquête, de reportages ou d’enquêtes de journalistes.

Les signataires réunis par le Future of Life Institute sont probablement sincères ou compétents. Certains semblent même avoir contribué aux avancées scientifiques en Intelligence Artificielle et possèdent une compréhension technique approfondie des systèmes en question. Mais leur focalisation exclusive sur la superintelligence déplace l’attention des responsabilités présentes vers des dilemmes futurs. Elle permet aux GAFAMs de poursuivre leur expansion tout en se drapant dans une rhétorique de prudence et de responsabilité. Elle transforme un débat démocratique et politique souhaitable sur la nature des contrôles de ces technologies, des intérêts économiques en jeu ou la nature des règles à appliquer, en un débat philosophique déconnecté de tout fondement sur la capacité d’une machine à penser. Pendant que cette question s’empare du débat public sur les plateaux TV ou au micro des radios, les effets indésirables s’accumulent d’un point de vue social, sociétal, culturel, environnemental, juridique ou économique, les victimes se multiplient, les effets négatifs collatéraux s’amplifient, et l’absence de régulation effective perdure renforçant ainsi la position dominante des grands acteurs industriels que sont les GAFAMs.

Soutenez Synth

Soutenez Synth

CET ARTICLE EST DISPONIBLE POUR TOUTES ET TOUS

Face à la domination des GAFAM et de leurs algorithmes opaques, nous vous aidons à reprendre la main sur les récits technologiques qui façonnent notre quotidien.

En soutenant Synth, vous co-construisez une voix forte, libre et indépendante. Vous pouvez faire un don à partir de 1€

Contribuez dès aujourd’hui avec un don défiscalisé à 66 %.

Chaque euro compte, et un engagement mensuel multiplie l’impact.

Statement on Superintelligence, Future of Life Institute, 2025